週刊エーアイElith: Issue #3

2023年2月6日ニュースレター

週刊エーアイElithでは、株式会社Elith(エリス)によって運用される日々の機械学習のニュース・OSS・研究・技術・学会・国内外AI企業の情報を毎週月曜日に配信するニュースレターです。

ニュースレターのコンセプトや概要、対象者、読み方については下の記事をご覧ください👍

AIニュース

AIニュースでは1週間でトレンドとなったニュースを紹介します。

2023年1月30日から2023年2月5日までのAIトレンドのニュースです。

Summari pivots to AI-generated link previews that really click

日本最大ユニコーンが家庭用AIロボットを発表。「名もなき家事」の解消目指すが…(BUSINESS INSIDER JAPAN)

Report: Microsoft plans to update Bing with a faster version of ChatGPT in the coming weeks

AI資金関連ニュース

AI資金関連ニュースでは1週間でトレンドとなったニュースを紹介します。

2023年1月30日から2023年2月5日までのAIトレンドのニュースです。

論文

今週は1月30日にSalesforceによって発表されたBLIP-2について解説します🧠

BLIP-2: Bootstrapping Language-Image Pre-training

with Frozen Image Encoders and Large Language Models**

論文からのアブストラクトの引用

大規模モデルをend-to-endで学習することを考えると、vision-and-language両方を事前学習するコストはますます法外になってきている。そこで本論文では、既存の凍結された画像エンコーダと、同じく凍結された大規模言語モデルを用いてvision-languageの事前学習をブートストラップする汎用で効率の良い事前学習手法である、BLIP-2を提案する。BLIP-2は、2段階で事前学習される軽量なQuerying Transformerにより、モダリティ間のギャップを解消する:第1段階として、凍結された画像エンコーダから視覚-言語の表現学習をブートストラップする。次に、凍結された言語モデルによって視覚から言語への生成をブートストラップする。BLIP-2は、既存の手法に比べて学習可能なパラメータが著しく少ないにもかかわらず、様々な視覚言語タスクにおいて最先端の性能を達成した。例えば、ゼロショットVQAv2において、BLIP-2は54倍少ない学習可能なパラメータでFlamingo80Bより8.7%高い性能を達成した。また本論文では、自然言語の指示に従いながらimage-to-textの生成を行うという、このモデルの新しい能力も実証する。

概要

Vision-Language pre-training (VLP) の研究は過去数年で著しく発展してきました。事前学習済みのVision-Languageモデルは、2つのモダリティを超える架け橋として様々な下流タスクに使用されています。その代表的なものにStable DiffusionやDALL•E 2などの画像生成モデルのテキスト理解に使用されているCLIPが挙げられます。

例に挙げたCLIPは、Vision-Languageモデルの有用性は広く知られているものの、最先端のVision-Languageモデルの事前学習には膨大な学習用データと計算コストを要するという難点がありました。

本ニュースレターで解説するBLIP-2はこの問題の対処を試み、汎用で計算効率の良いVision-Languageの事前学習手法として既存の視覚モデル・言語モデルからのブートストラップを提案します。

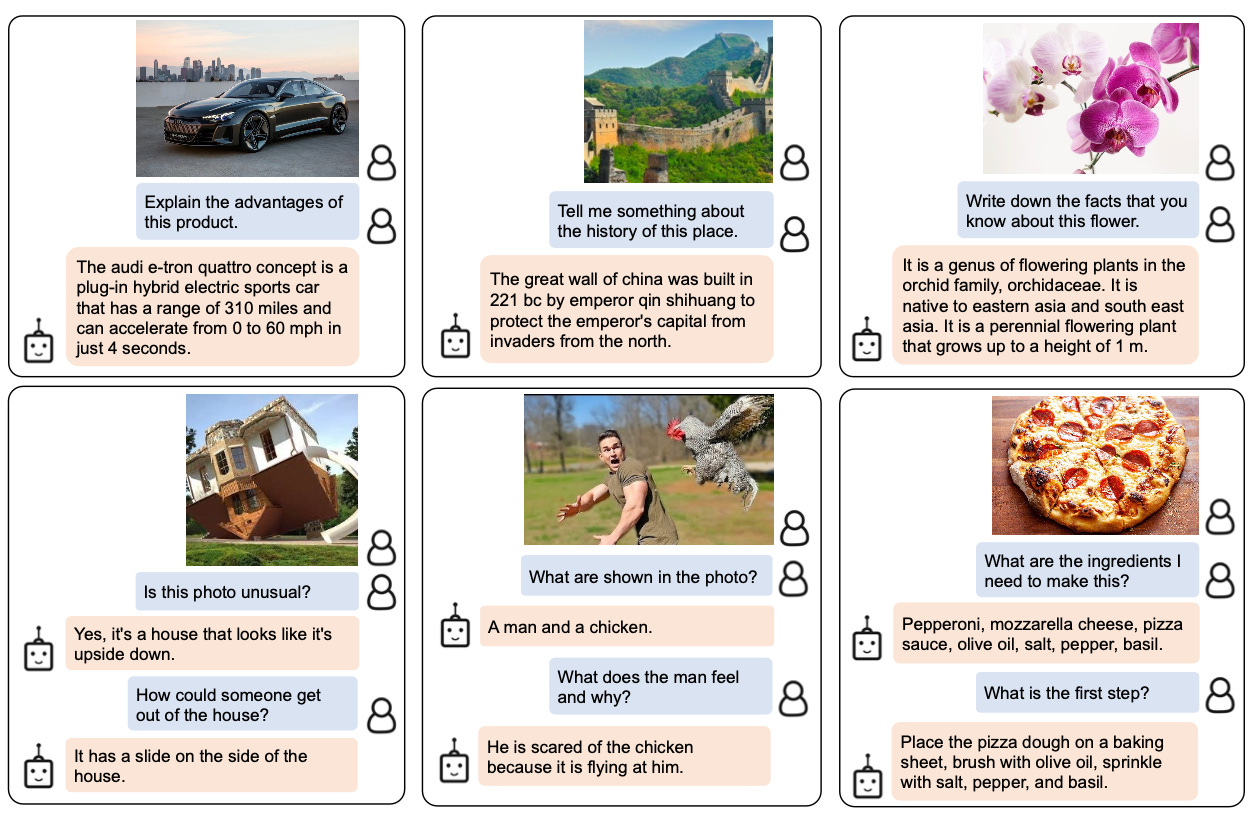

BLIP-2は、既存の視覚モデル・言語モデルを凍結して内部に組み込んだ上で2段階の事前学習を行いました。これにより、視覚・言語両方の高度な理解を獲得しました。例えば、以下の画像に示すような会話を交わすことも可能です。

論文から引用

技術

特筆すべき点は、以下の2段階に分かれた事前学習の手法です。

画像の埋め込み表現とテキストの入力を受け、テキストの表現と最も類似する埋め込み表現を出力するQ-Formerを学習する

論文から引用

Q-Formerの出力を入力とし、言語モデルに入力することで適したテキスト出力を得られるような埋め込み表現を出力とする全結合層を学習する*(メモ:これ以外に良い表現が思いつきませんでした。)

論文から引用

既存の事前学習済み視覚モデル・言語モデルの接合によってVision-Languageモデルを作成するというアイデアによって、新たに学習する必要のあるパラメータ数を100M程度にまで減らすことに成功しました。加えて、end-to-endで学習されたVision-Languageモデルにも劣らない性能を獲得しています。

論文から引用

課題

近年の大規模言語モデルでは文脈の中で少数の例示を与えるとパフォーマンスが向上することが知られているが、BLIP-2のVQAタスクにおいて同様の手法による改善は見られなかった。

著者らは、1サンプルにつき1つの画像・テキストペアを与えるBLIP-2の事前学習用データセットに原因があると考えている

BLIP-2は、既存の言語モデルを内部に組み込んで知識を使用するため、言語モデルから誤りや偏見を継承してしまうリスクがある。

参照

機械学習系OSS

機械学習系OSSでは利用者の多いOSSのリリース情報を中心に解説します。

リリース

OSSの更新はありません。

技術コラム

技術コラムでは毎回テーマを決めて機械学習に関連する技術を紹介します💻

ByteTrack

参照:https://arxiv.org/abs/2110.06864

今回はMOT(Multi Object Tracking)の手法の一つであるByteTrackについて解説します。

ByteTrackは以下の画像に示すように、高精度と高FPSを実現します。

論文から引用

MOTは、物体検出モデルとトラッキングのアルゴリズムを組み合わせます。今回はBYTEと呼ばれるトラッキングのアルゴリズムについて紹介します。

従来の手法の一例としてDeepSortを紹介します。DeepSortはまず、同一人物判定モデル(ReIDモデル)によりフレーム間の人の紐付けを行います。次に、紐付けできなかった人に対してカルマンフィルタ(Sort)で計算したBoundingBoxの移動予測によりフレーム間の紐付けを行います。しかし、DeepSortでは、紐付けは信頼値(Confidence Score)が大きなBoundingBoxに対してのみ行われます。これはFalse Positiveを下げる一方、True Positiveも下げることになり、性能は頭打ちになります。

ByteTrackは、Confidence Scoreの低い人物の紐付けも行うことができるモデルです。以下の画像に示すように、人物が重なりConfidence Scoreが低くなった物体のトラッキングを行うことができます。(赤枠)

論文から引用

BYTEというトラッキングのアルゴリズムを紹介します。

まず、tracklets(追跡中の人物情報のリスト)に含まれる次のフレームの位置をカルマンフィルタで予測します。そして、Confidence Scoreの高いDetection Box(検出された人物)をtrackletsに含まれる人物(ID)と紐付けます。

次に、高いConfidence Scoreと紐付けられなかったtrackletsを低いConfidence ScoreのDetection Boxと紐付けます。

アルゴリズムは非常にシンプルであるため高速に動作します。以下にアルゴリズムを添付します。

論文から引用

学会

学会では直近の学会情報をお伝えします!今後は学会のレポートなども配信予定です!

直近で開催予定の人工知能系の学会

直近で終了した人工知能系の学会

書籍

ソフトウェア開発やビジネスに役立つ書籍を紹介します📖

インビンシブル・カンパニー 「無敵の会社」を作った39パターンのビジネスモデル

アレックス・オスターワルダー (著), イヴ・ピニュール (著), フレッド・エティアンブル (著), アラン・スミス (著); 翔泳社 (2021/1/18)

ビジネスを探索と活用に分けて説明し、組織のリーダーや企業家へ向けて無敵の会社を作る方法を解説。 有名企業のポートフォーリオとビジネスモデルが紹介されていて、事業アイディアが浮かんだときの整理や壁打ちにも。

エンジニアリングマネージャーのしごと ―チームが必要とするマネージャーになる方法

James Stanier (著), 吉羽 龍太郎 (翻訳), 永瀬 美穂 (翻訳), 原田 騎郎 (翻訳), 竹葉 美沙; オライリージャパン (2022/8/26)

エンジニアリングマネージャーにとって必要な考え方やアドバイスをくれます。他者と関わり自分と向き合う実践の書。